脸书、领英、推特的A/B测试为什么难做?

原创:MarTechApe

A/B测试的概念听起来很简单:将用户随机分配到对照组或实验组,并检查与对照组相比,实验组中的用户是否表现出了预期的行为变化(或根本没有变化)。但是,如果用户彼此互动,彼此影响,那么将实验组和对照组完全分开就变得几乎不可能。

像Facebook,Google和LinkedIn这样的公司都因广泛使用A/B测试而知名。但是,鉴于其产品的高度互连性,这几家公司都面临着上述问题,这可能会给实验结果造成偏差,甚至可能损害其用户的体验。那么这些公司如何解决这些问题呢?

社交网络中A/B测试的挑战

在进行A/B测试时,通常会假设测试中每个人的回答仅取决于自己的意志和体验,而不取决于其他人的意志。这称为个体处理稳定性假设(SUTVA)。但是,我们假设大型社交网络平台(如LinkedIn或Facebook)测试了一种改进后的算法,以使其推送内容与用户更加相关,目的是增加用户与内容的互动频率。如果用户A在实验组中并与对照组中的用户B连接,则用户A的行为变化可能会影响用户B的行为。用户A可能对推送上改进的内容表现出更高的参与度,因此开始分享更多的帖子,图片和文章。这最终将对用户B产生影响,使得用户B在没有享受改进内容的情况下与用户A做出了同样的反应。

实验的成功以实验组与对照组之间平均结果的差异来衡量。例如,你可以检查转化率的差异。这被称为平均实验效果(ATE)。像在社交网络中发现的那样,溢出效应使平均实验效果产生偏差,因为此时实验组的收益已经无法被准确的评估。对于新的推送算法,溢出效果可能不仅会导致实验组的参与度增加,而且对照组的参与度也会相应地增加。这是因为在这种情况下,对照组中的用户会更容易受到他们在实验组中朋友的“鼓励”和带动而提高参与度。但是,这其实削弱了实验组对于新功能的积极效果,因此在社交网络中使用标准A/B测试方法时,最终可能导致错误的结论。

除了统计结果偏差的风险外,在社交网络或协作应用程序中进行A/B测试也可能会给用户体验带来一些挑战。例如,在视频聊天程序或涉及高度协作的程序(例如Google Docs)中测试新功能时, 如果进行视频通话或在同一文档上进行协作的用户拥有不同的功能,则可能会导致用户体验恶化,并引发诸如“你看不到右下角新的黄色按钮吗?”的问题。

因此在社交网络中,A/B测试的经典方法可能会由于统计结果的偏差而误导商业决策,同时严重损害用户体验。那么应该如何解决这个问题呢?

整群抽样

整群抽样,也称为网络存储,是处理溢出影响的常用方法。目标是将用户分为实验组和控制组,因此各组之间的交互会尽可能降到最低。进行AB测试时,通常会将用户随机分配给不同的变量,从而导致上述溢出效应。而整群抽样的随机化是在用户群集级别上进行的,换句话说,如果一个用户被分到了控制组中,则他直接联系人中的很大一部分也将分配给控制组。

▲ 社交网络中的整群抽样

以最小化组别之间信息流的方式拆分这些组非常复杂且具有挑战性,因为这其中需要使用多种不同的聚类算法来实现此目标。一种称为e-net的方法基于以下思想:

查找k个节点作为聚类中心,它们之间的距离大于一个特定值

将其余节点随机分配到其最近的中心

在协作应用程序(例如Google Cloud Platform)中,可以使用更具确定性的方法来创建这些集群。彼此交互的用户数量受到他们一起工作的项目数量的限制。因此,可以创建在相同项目上工作的用户集群,从而将集群之间的溢出效应降低到接近于0(如果用户加入了其他集群用户创建的新项目,则仍然会发生溢出效应)。

对实验组进行聚类的过程中也伴随着挑战。例如,在网络中的群集大小和群集数量之间需要权衡。一方面,为了获得A/B测试的高统计能力,最好有尽可能多的群组。另一方面,用户组中完全不同的群集数量越多,这些群集的隔离度就会越低。例如,如果只有一个或两个集群,则溢出的数量将远远少于有100个或更多集群的情况。另一个要求是各个实验组需具有相同的群集大小,这可以帮助减少差异,并提高测试的效能。

A/B测试集群

一旦将用于实验的用户以集群的形式进行整合,就可以将集群分配给控制组和实验组。然后再以集群为单位进行测试。诸如转化率之类的指标首先在集群水平上计算,然后再在控制组和实验组分别取平均值。最终,这些结果可用于计算平均实验效果。

通常,该方法也可用于证明网络效应的存在。例如,在运行实验时,可以在用户级别上将具有随机化的A/B测试与在集群级别上具有随机化的另一个测试并行运行。如果两种设置之间的平均实验效果存在显著差异,则可以将其视为存在网络效应的证据。

进一步的挑战

在集群而非用户级别上进行随机化测试只能解决在社交网络中进行A/B测试时出现的部分问题。另一个要考虑的问题是将用户划分为集群时用户之间的连接强度和方向。社交网络中的KOL就是一个很好的例子。与Facebook或LinkedIn相比,Instagram和Twitter等社交网络具有非常不同的结构。在这些网络中扮演重要角色的KOL是相对较小的用户群体,却能够对大量用户产生巨大的影响。同时,这些联系中的大多数都是单向影响的:KOL可以对其追随者产生影响,而追随者却无法对KOL产生影响。想象一个极端的情况,一个用户影响力极高,以致于网络中的所有其他用户都关注了他。无论如何划分网络,该用户都可以影响所有用户。但是,在不太极端的情况下,仅通过将具有最接近连接的用户分组到集群中,也可能无法减少溢出效应。解决此挑战的一种潜在方法是使用KOL作为初始集群中心,并将其余用户分配给这些集群。

结论

一般来说,A/B测试是一个被广泛使用且经过充分研究的领域。同时,当在社交网络中进行A/B测试时,所面临的挑战尚未解决,仍需进行深入研究。无论是寻找正确的集群方法还是平均实验效果的理想估计量,仍然有许多问题需要克服。但是,A/B测试是Facebook和Twitter等大型科技公司产品开发过程中的核心,因此我们可以预见,克服这些挑战的新方法很快就会被开发出来。

由于A/B测试的重要性,掌握了A/B测试,就等于获得了通往科技大厂的敲门砖。想要积累实战经验,丰富履历,在面试中更胜一筹吗?MarTechApe的《A/B测试企业级实战训练营》以真实商业场景中的复杂A/B测试问题为项目背景,让学员在两个月的时间里,使用百万量级原始数据,搭建完整的A/B测试流程。

在过去开办的三期《训练营》中,我们为顶尖科技公司输送数据能力强、实验经验丰富、统计基础扎实的数据人才。不论你本来是什么背景,都能通过这门课程,打开盛行“测试文化”的互联网高科技公司的大门!

以下为往期学员的战绩榜:

《A/B Testing Bootcamp》往期学员拿到的面试机会以及全职工作OFFER包括Facebook、Amazon、TikTok、Viagogo、GSK、Walmart、Pinterest、Chegg、Wish、Twitch、Plymouth Rock、Nintendo等互联网科技公司。

今天,MarTechApe《A/B测试企业级实战训练营》第4期正在火热报名中🔥!

每一期训练营,我们只招收20名学生。先到先得,遵循阶梯价位,优惠逐额递减,越早报名越优惠!

1. 你将获得

真枪实弹的A/B测试项目实操,百万量级真实数据+五大应用案例,从零学会A/B测试的里里外外!

为你建立一个完整的、专业的、深度还原大公司的的A/B测试项目,让你在面试时可以自信展示自己亲自做的案例,成功拿下offer!

从0到100真实操作A/B测试项目的全套流程:数据清洗、数据自动化处理、实验设计、实验执行、结果分析、报告展示。

经历真实工作场景中的、各大互联网科技公司里使用的A/B测试流程,以及适应不同商业场景的各类实验/准实验方法。学会工作中最重要的分析方法!

深度学习A/B测试实战中常见的测试陷阱及避免方法。

牢固掌握公司里A/B测试项目中的实际SQL与Python应用,为A/B测试搭建数据库、清理数据、创建数据集。

学会用Python自动化实现A/B测试,为你的老板提高100%的工作效率!

接受系统的统计训练,打下坚实牢固的统计基础,彻底明白A/B测试的统计原理、分析方法、实验设计方法、抽样准则。

各大互联网、科技公司A/B testing面试题解题步骤示范与详细解析。对互联网科技公司的深度剖析和指标介绍,让你自如面对各类面试考验!

专业的Bootcamp经历简历模版与认证证书,可以晒到LinkedIn等求职网站,大大提高面试邀请率!

福利升级:训练营以往只内推成功从训练营中毕业的学生。但在疫情期间,所有A/B测试实战训练营学员,均可获得全职或实习岗位的内推机会!

2. 训练营老师介绍

Emma老师

美国知名电商Wayfair高级商业分析专家

拥有多年电商A/B测试实战经验,及新人教授经验

精通Advanced SQL, Python等数据分析工具

设计推出的A/B测试,为公司带来上千万美元的收入

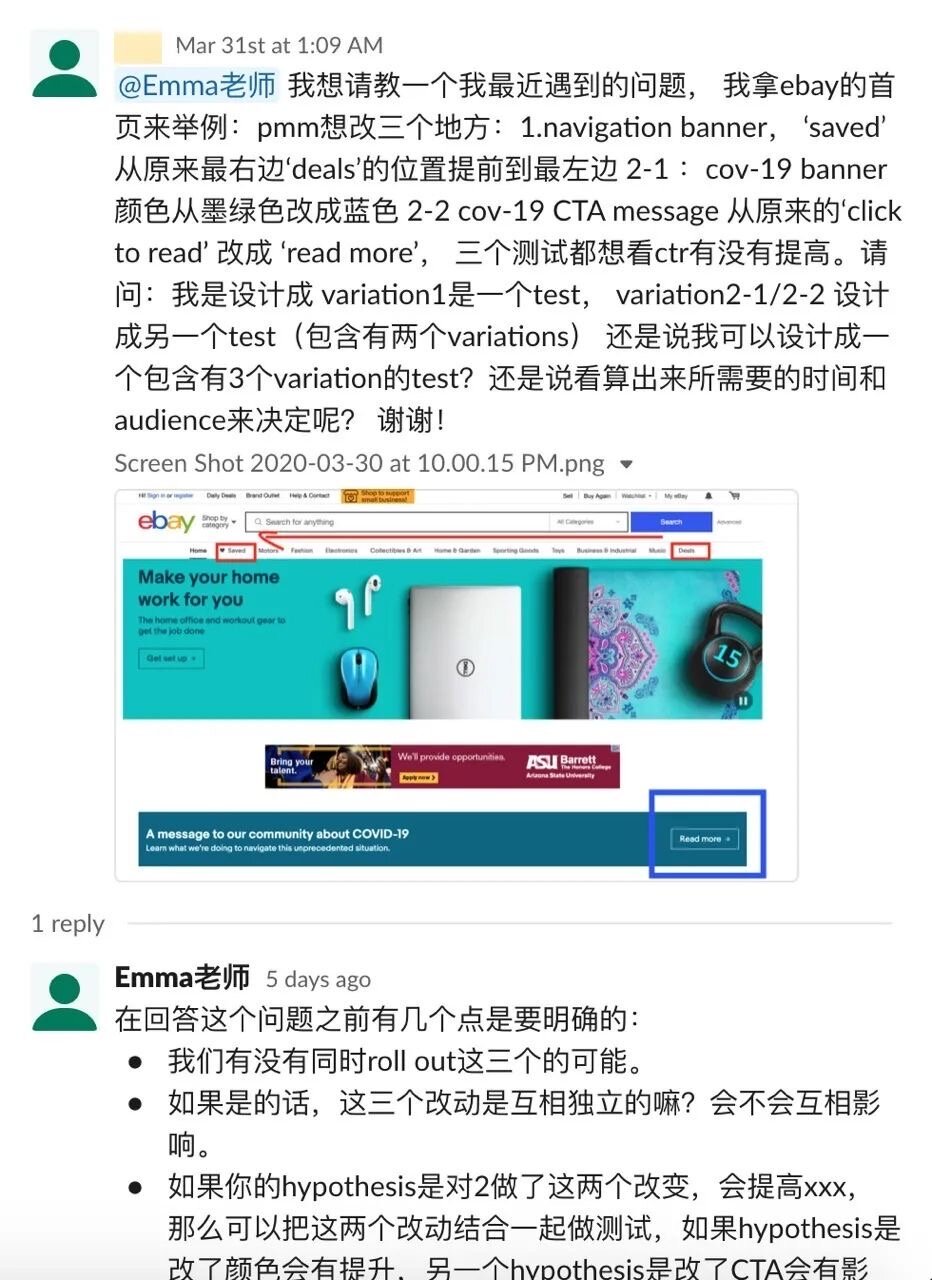

Emma老师对学员知无不言,有问必答!无论是面试中遇到的问题,还是工作中遇到的困惑。

3. 训练营课程内容

整个Bootcamp历时8周,每周3小时课程,共计24小时课时。

周末线上实时授课,课后完成老师布置的作业,助教团队在班级群内随时答疑,直播录像永久回放。

五大课程模块:

A/B测试商业训练(案例、变量设计、测试计划)

A/B测试数据技能训练(数据源概况、SQL数据库建立、Python自动化分析)

A/B测试实验设计训练(A/B测试 vs 准实验、实验步骤、真实商业环境中的实验挑战)

A/B测试统计训练(统计分析、深度解析)

A/B测试面试训练

课程内容涵盖了A/B测试在各大互联网科技公司中的完整工作流程:

A/B测试统计基础与应用场景

A/B测试实验设计

A/B测试假设检验、变量选择、流量计算与实验周期计算

A/B测试各类应用场景中的实验变体与前后测实战分析

用SQL与Python完成A/B测试项目实战

A/B测试结果解读与高阶统计

结果展示

每位学员将有一套亲自做的A/B测试成果作品

每位学员获得A/B测试面试真题解题辅导

结课后,每位学员获得提升简历的Industry Project Experience完美描述,所有学员获得内推机会!

1. A/B测试商业训练

了解A/B测试在顶流科技公司中的各类应用场景

了解A/B测试适用的商业问题与它的局限

了解科技公司产品团队如何使用A/B测试

面对商业问题,如何设计有效的假设?

如何制定A/B测试的实验计划与执行框架?

2. A/B测试数据技能

搭建一个真实的A/B测试实验数据库

了解A/B测试中常面临的数据问题

用SQL对数据进行清洗与转制,完成样本选取、组别分配、变量选取等实验步骤,为A/B测试做好数据准备

用Python搭建A/B测试分析流程

学员在项目中重点使用SQL与Python,全方位了解A/B测试中涉及的数据库搭建、样本选取、实验组与测试组分配、变量选取等数据分析步骤。并且充分掌握用Python搭建A/B测试结果分析流程,实现A/B测试自动化,对真实工作中的A/B测试分析了如指掌。简而言之,项目后,你不仅将牢固掌握SQL与Python等最热门的数据分析软件,还将成为真正的A/B测试技术流,完全掌握A/B测试这项数据分析工作中最重要的技能。

3. A/B测试实验设计

充分了解A/B测试的实验步骤

设立零假设与被择假设

确认实验指标,设计实验变量

根据指标类型确认统计检验方法

估算样本量,确定实验周期

置信区间与统计功效

A/B测试中的各类偏差

样本量不够或其他实验条件不满足时的实验设计

了解准实验与A/B测试的应用区别

为项目案例设计A/B测试实验

学员在项目中将透彻学习实验方法与实验设计。在这个环节中,将研究如何制定实验方案,以提高实验效率,缩小随机误差的影响,并使实验结果能有效地进行统计分析。学习在工作场景中如何用A/B测试等实验来提高用户激活/活跃/留存等关键的产品指标,提升产品功能表现,真正理解A/B测试的商业价值与业务地位。

4. A/B测试统计训练

抽样技术

样本量与统计分布

统计测试的不同类型和指标(T测试, Z测试, Z分数, P值)

统计显著性

统计功效

置信区间

假设检验的两类错误等

学员在项目中将系统学习数理统计方法,为各类工作实战中的实验方法打下牢固的理论基础。学员所学习到的统计并不只适用于A/B测试,其实是所有数据分析方法的从基础到高阶的统计方法。只有为自己增添坚实的统计背景才能在各类分析方法中游刃有余。

5. A/B测试面试训练

在每周的课程后,所有学员将获得A/B测试面试训练。老师将对各大互联网、科技公司A/B测试面试题给出解题步骤示范与详细解析。确保课堂所学知识可以灵活应用到各类面试场景,助你自信面对A/B测试的所有面试考验!

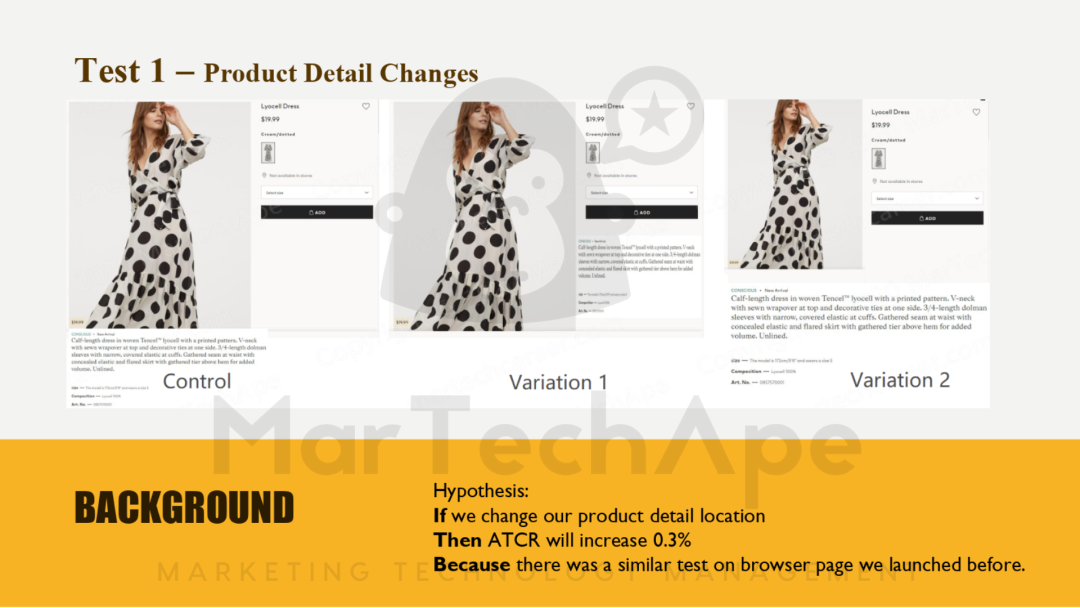

4. 训练营学员作品

上完Bootcamp,有哪些作品可以展示呢?

从数据库搭建、样本选取、实验组与测试组分配、变量选取、实验设计,到实验结果深度分析与PPT展示,学员的精致项目报告就是他们最好的训练营成果,这一份拿的出手的高品质项目,无论是LinkedIn还是面试展示,都会是脱颖而出的最佳帮手!

部分学员作品展示:

5. 报名方式

长按二维码,添加小助手为好友,回复“AB”,即可报名《A/B测试实战训练营》:

小助手(微信ID:yvonne91_wsn)

熟悉我们的老用户,应该知道我们一直都是实行阶梯价格、优惠递减的,这次也不例外:先到先得、越早报名越优惠(原价$1999美元)。以下价格单位为美元:

第1名~第5名:1299美元(立减$700)

第6名~第10名:1499美元(立减$500)

第11名~第15名:1599美元(立减$400)

第16名~第18名:1799美元(立减$200)

第19名~第20名:1999美元(原价)

你是否能在更好的公司做更优秀的自己?投资自己,全方位提升能力,为自己增添被验证有效的宝藏项目经历!赶快报名吧!